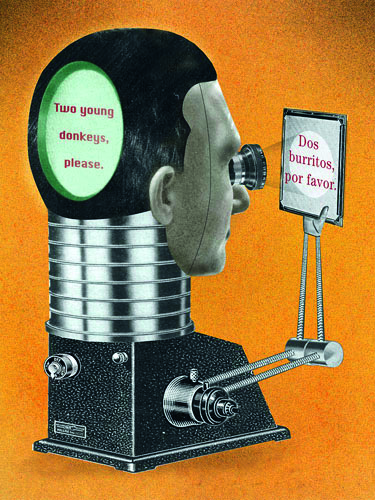

不用再学第二语言,借助机器翻译就能完成不同语言间的信息转换——这曾是很多人的梦想,为了这个梦想,机器翻译在20世纪中期逐渐兴起,成为炙手可热的研究领域。

刚开始研究机器翻译时,很多科学家试图从句子的语法出发,通过分析一个句子的结构、词性和时态等信息后,解构信息,再按另一种语言的标准语法重构信息,完成翻译。当时的语言学家和计算机科学家都对这种思路充满了幻想,希望利用计算机强大的分析能力,实现人们的梦想。

但是,几十年过去了,梦想却没有成真。一方面,分析句子并没有想象中简单。在日常使用中,口语表达具有很大的随机性,即使在书面表达中,复杂的修饰关系也让句子分析难以准确而高效地进行。另一方面,以语法规则为基础的机器翻译很难处理一词多义的情况。这个问题在很多语言中都普遍存在,简单通过语法规则的对应关系做翻译,很难找出符合语境的意义。

到了20世纪80年代,多次碰壁让从事规则翻译研究的科学家灰头土脸,热情逐渐被磨灭,而机器翻译准确性的低下,也让这个研究领域的经费被一再削减。

统计翻译崛起

然而,在这种令人颇为失望的背景下,一种与规则翻译完全不同的方法,在人工智能的浪潮中渐渐浮出水面。彼得·布朗(Peter Brown)是美国著名计算机科学家,当他还在IBM工作时,提出了一种创新性十足的想法:用统计的方法实现机器翻译。布朗认为,通过统计大量样本中相邻词语间的关系,也许更有可能在另一种语言中找到表意相近的句子。

由于缺少做好标记的双语资料,无法获取足量的统计数据,布朗的方法并没有在一开始就取得很好的效果。不过,这个障碍很快就被跨过去了,因为大量涌入人工智能行业的科研人员对自然语言处理充满兴趣,对他们来说,解开语言背后的秘密就像是解开智能的秘密一样,让人兴奋,原本因为缺少数据量造成的障碍也不再是问题。当时,宾夕法尼亚大学的米奇·马库斯(Mitch Marcus)教授带领了一批人专注于建立语料库,IBM沃森实验室的弗里德里克·贾里尼克(Frederek Jelinek)也卯足了劲,建立自然语言处理的最佳模型。

20世纪末,规则翻译仍在吃力地提升翻译的准确度,而统计翻译却在一片质疑声中快速成长。大量从事规则翻译的人很难接受这种新的方法,不按语法规则处理语言,就能提高翻译的质量?这似乎有点天方夜谭,因此,持不同方法的两方经常在国际比赛中对垒。在各大赛事中,人们亲眼见证,统计翻译正在追赶,甚至超越规则翻译的准确率。

统计翻译能够快速发展,是因为科学家为这个过程找到了一个数学模型。当时投入算法研究的贾里尼克发现,科学家可以用统计的方法计算一个句子存在的概率。比如:“谢尔顿想在7月时来北京做学术访问。”这句话结构清晰,逻辑明确,任何能够阅读文字的人都能很快知道它在讲什么。对数学模型来说,却不用在乎结构和逻辑如何,它只需拿句子中出现的词语和词语组合与标准语料库中的数据做对比。如果存在大量类似的表达,这种表达就会获得一个比较高的概率估值;如果只有少量对应的表达方式,甚至没有对应的表达方式,这种表达就只能获得很低的概率估值。通过逐一对比一句话中的词语组合,机器就能算出一句话存在的概率有多大。综合对比不同的组合方式,系统就能选出存在概率最大的一句,作为翻译的最终结果。

可以想象,当我们看到“学术北京想七月做谢尔顿访问”时,肯定会一头雾水,完全搞不清楚这句话想要表达什么。计算机接收到这句话,并和语料库对比时,也会出现同样的问题,“学术北京”不是一个常见的表达,“北京想七月”也不常见,“七月做谢尔顿”和“谢尔顿访问”也都不是常见的表达。每个基本单元都只有很低的概率估值,最终的计算结果也会出现同样的情况,整句话的概率估值过低,在概率排名时完全无法胜出,机器会直接抛弃这样糟糕的结果。

词语的组合方式是判断概率时非常关键的基本单元,如何构建这个基本单元在当时也引起了很大的争议。到底应该综合多少个词来判断一句话的概率?预设一个词的出现与整句话的所有词都有关,还是只计算这个词和前一个词的组合?多番讨论和实践下,在句子中第N个位置上出现的单词与前面N-1个词相关的预设成了主流,这也奠定了现在非常流行的N-gram模型(这里是指语言模型)的基础。这套模型出现后,科学家又逐渐改进,将基于词的匹配转向基于短语的匹配,再加上大规模平行训练语料的应用,最终使统计翻译的正确率直接超过了规则翻译的水准。

实际使用中,一般会在N-gram模型中选择N等于4或5的情况。也就是说,科学家会使用四元或五元模型,让句子中某一个词的出现概率与前面3个或4个词有关。这样做可以大幅减少概率计算时产生的工作量,同时输出可以接受的成果。谷歌在国际竞赛中也使用过更多元的模型,在计算概率时,这些模型对计算量的需求都是以指数形式增长的。可惜,飞速增长的计算量并没有使更高元的模型表现更好,在具体的应用环境中,四元和五元模型仍然占据主流地位。

2007年,谷歌借助基于N-garm的罗塞塔翻译系统在一次公开的机器翻译竞赛中战胜了规则翻译系统,获得了第一名。这场成名之战让基于N-gram的统计翻译系统迅速普及,大量院校和研究所开始投入更多的人力和物力,试图推动这个领域快速发展。

中文困境

“国内很早就引入了基于N-gram的统计机器翻译,”中国科学院自动化研究所的副研究员张家俊告诉《环球科学》记者,“因为是基于统计学原理,有很多模型都不用考虑繁琐的语法规则,只要把中文分词的工作做好,积累足够优质的语料库,就能很好适用于中文。”

在实际应用中,语料库的质量和规模对统计机器翻译至关重要。当年,马库斯在美国自然科学基金会的支持下, 建立了LDC(语言数据联盟),他们试图为几种主要的语言(英语、汉语等)建立可供计算语言学或自然语言处理研究使用的高质量、大规模语料库。一些留学美国的中国留学生为汉语语料库构建规范的制订做出了重要贡献。几乎在同一时间,国内学者也开展了对汉语分词语料库和汉英双语词汇知识库的研究和开发工作。

“语料库的质量和规模对于统计自然语言处理,包括统计机器翻译系统研究来说至关重要。”中国科学院自动化研究所模式识别国家重点实验室副主任宗成庆研究员表示,“但是,即便人工建立的语料库和语言知识库规模再大,也难以涵盖所有的、不断变化的语言现象,因此,如何研究实现基于互联网内容的语言知识和翻译知识自动学习和更新算法,显得尤为重要。”

美国国家标准与技术研究院(NIST)每年都会举办关于机器翻译的竞赛,为了保证测试结果的可对比性,竞赛会统一使用由LDC提供的语料库和数据集。这给中文本土语料库的发展造成了多方面的影响。研究人员在构建模型、调整参数时,会优先选用由LDC提供的数据,使本土的语料库得不到足够重视;即使有科学家做了语料库整理的工作,也会优先投递给LDC,好让自己的工作更有影响力;不仅如此,语料库的使用需要支付一定的授权费用,费用流失后,更难激发工作人员主动整理非常耗时的语料库资源。

国内也有类似的竞赛机制,全国机器翻译研讨会(CWMT)每两年会举办一次翻译质量评测,评测组织方会给出有待训练、开发和测试的数据,并要求在规定时间内返回结果,提交技术报告。不同的是,除了英汉互译,还会测评藏语和蒙语等少数民族语言与汉语的互译。

但问题还是相似的,由于缺少基础层面的原创工作,语料库也有很大的进步空间,中文机器翻译的实际表现并不尽如人意,无法达到无障碍理解的程度。

“把机器翻译用在表达比较规范的文本中,效果还挺好,”宗成庆告诉《环球科学》记者,“比如国内有大量基础资料有待翻译,每年也会产生大量专利文案和办公室文档,机器翻译完成这项工作的速度可比一般人力快得多,当然,也省钱得多。”

向深度神经网络过渡

信息科学的浪潮还在不断翻腾。最近在图像识别和语音识别中取得巨大成就的深度神经网络技术也逐渐侵入了机器翻译领域。从本质上来讲,深度神经网络也是通过对比计算概率,算是和统计翻译一脉相承,只是它对并行计算量的需求极大,近几年计算机硬件高速发展后,才逐渐流行起来。

“我们之前一直在做统计翻译,近两年也开始切入基于深度神经网络的机器翻译了,”张家俊说,“现在的趋势是神经网络的翻译模型会超越统计翻译模型。”

2016年5月,谷歌直接宣布将基于神经网络的语法分析架构SyntaxNet开源,利用这款号称最强的语法分析器,开发者可以按需选取数据训练自己的SyntaxNet模型,大幅提高表意的相关性,从而拉升翻译质量。随后,Facebook也在6月宣布利用29层深度卷积网络处理自然语言,取得了明显的进展。同时,Facebook还称,这是第一次将深度卷积网络应用在自然语言处理中,只要架构合理,神经网络的深度就会与自然语言处理的性能呈正相关。这很有可能会在机器翻译领域中引发“数字竞赛”,就像现在在图片识别领域中比拼谁能把神经网络的层数做得更多一样。

“目前技术的进展很快,深度神经网络的应用正在逐步发挥作用,应用的场景也会更广,” 哈尔滨工业大学的关毅教授长期从事自然语言处理的研究,他说,“我们希望通过自然语言处理挖掘出更多可以直接为人们的生活提供便利的信息。”同时,微软也想利用在语音识别方面积累的技术,将它与基于深度神经网络的机器翻译结合,从而在Skype上实现实时语音翻译。

现在,计算机语言学家和大众都对机器翻译技术充满了幻想,试图借助计算机强大的分析能力,让人们不用费力学习新的语言,用机器翻译系统及时完成不同语言间的信息传递。这一次,科学家的梦想能成真吗?

请 登录 发表评论