通过自我对弈持续提升棋力

根据论文显示,跑在集群上的完整版AlphaGo在2015年10月与樊麾一战时棋力比樊麾大约高出230个等级分,但它挑战的“围棋传奇”李世石比樊麾大约高出630个等级分,而目前世界等级分排名第1的中国棋手柯洁比樊麾高出大约730个等级分。也就是说2015年10月的AlphaGo为了战胜李世石,还需要再提升至少400个等级分。

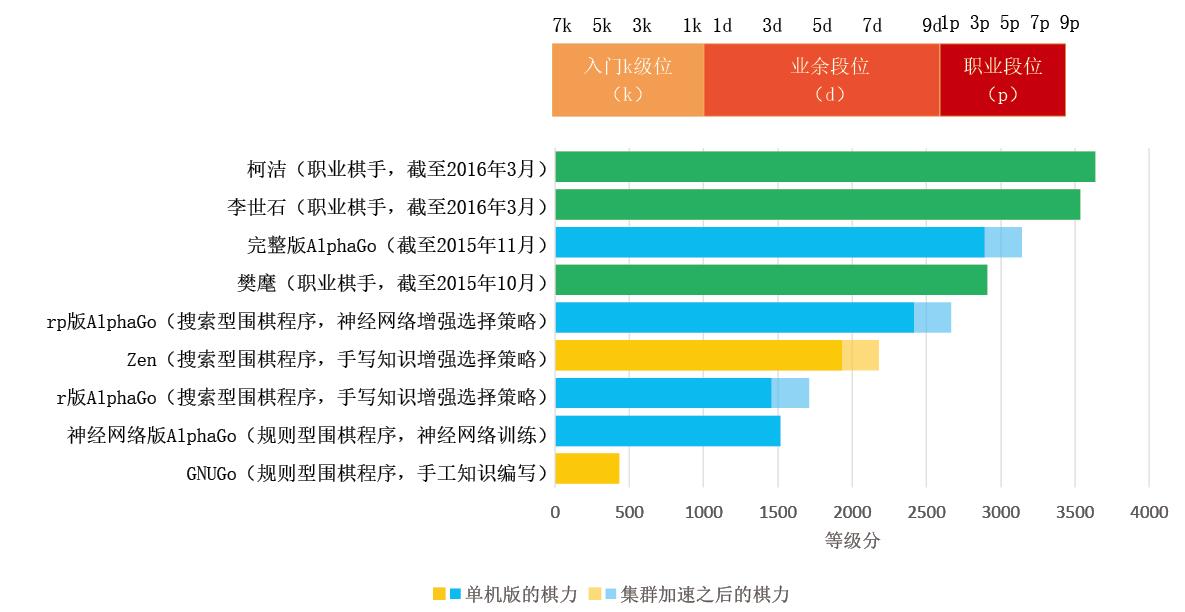

图 围棋程序与人类职业棋手的棋力对比

图中等级分相差230分意味着单局胜率接近80%,五番棋胜率接近95%。根据图中数据,跑在集群上的完整版AlphaGo在2015年10月与樊麾一战时棋力已经比樊麾大约高出230个等级分。作为比较,AlphaGo挑战的“围棋传奇”李世石比樊麾大约高出630个等级分,也就是说AlphaGo想战胜李世石,就需要在这几个月时间里再提升400个等级分。而目前世界等级分排名第1的中国棋手柯洁比樊麾高出大约730个等级分。图中人类棋手等级分来自http://www.goratings.org/网站;围棋程序等级分来自AlphaGo论文,其数值是以樊麾等级分为基准,使用与人类棋手相同的评分方法计算得出。这里的段位是KGS段位,不是中国段位。

为了继续提升棋力,AlphaGo还有一个绝招,就是通过自我对弈的方式迭代提升棋力。战胜樊麾时的AlphaGo是通过一个来自人类业余高手对局的数据集训练而成。此时的AlphaGo既然能战胜樊麾,其自身棋力必然已经超过了原有数据集中业余高手的水平,那么开发团队就可以通过让这个更强的AlphaGo自我对弈,从而产生大量新的对局数据,然后再用这个质量更高的新数据集来训练出比战胜樊麾时更强的神经网络和围棋程序。理论上,这样一个“数据产生更强程序,而程序又反过来产生更好数据”的迭代过程可以一直进行下去,使得AlphaGo变得越来越强。当然,这个自我提升过程并不会使AlphaGo变得无限强,而是会逐渐趋于一个极限棋力。至于这个极限到底有多高,恐怕只能通过与人类顶尖棋手的实战才能知道。

(本文发表于《科学世界》2016年第4期)

请 登录 发表评论