像许多研究人员一样,我经常但不很情愿地利用电视会议。人类的交流包含语言的和非语言的两大要素,而电视会议不能巧妙地传达非语言要素。例如,今天的电视会议系统不能恰当地借眼光的交流来表达思想,因为摄像机和显示屏不可能处在同一地点。这通常使得交流的效果麻木而刻板,因为眼光的交流乃是取得互相信任的一种几乎普遍的下意识方法。不仅如此,电视会议的参与者不可能取得彼此间的相互位置感,因而没有明确的方法来引导注意力,表示赞同或反对。

远程沉浸是数字技术造就的一种人类交流新媒体,它近似于一种幻境,即使其他参与者事实上可能位于千里之遥,你也似乎觉得与他们处于同一物理空间。它将虚拟现实的显示和变流技术同超越照相机传统极限的新视觉技术结合了起来。远程沉浸站不是仅仅通过一点来观察人及其周围的环境,而是不看重某一单个视点,将人作为“活动的雕像”来进行传送。结果是不管距离多么远的参考者都能共享和探索与现实生活中大小一般的空间。

除了改进电视会议之外,远程沉浸还被设想是推动网络工程研究,特别是对Internet2的一种理想的应用(Internet2 是美国一家主要的进行高级网络研究的集团公司)。如果一个计算机网络能够支持远程沉浸,那末它也许就能够支持任何其他的应用。这是因为除了对大容量和高可靠性通信的较普通的要求外,远程沉浸还要求尽可能小的信息流延迟(以及很小的延迟不一致性)。

虚拟现实和网络

由于远程沉浸处于虚拟现实和网络研究以及计算机视觉和用户界面研究的交叉路口,因此,稍具这些不同研究领域的背景知识是适当的。

1965年,被普遍认为是计算机图形之父的Ivan Sutherland,提出了他称为“终极显示器”的东西。这种显示器将让用户体验一种完全由计算机描绘的空间,就好象这种空间是真实的一样。Sutherland借用美学特别是Suzarme KLanger著作中的一个术语,命名这种空间为“虚拟世界”l968年,Sutherland藉助一种被称为头戴显示器的装置第一次使虚拟世界变为现实。这种装置乃是一个头盔,在双眼前方装有一对显示屏,给配带者一种沉浸在三维立体空间中的感觉。当使用者摆动他或她的头部时,计算机会快速重新计算每只眼前的图像以维持那种幻觉,即计算机描绘的世界在用户观察它时是保持固定不变的。

在2O世纪8O年代期问,我无意地创办了经销用以创建和体验虚拟世界的通用工具的第一家销售公司。这在很大程度上得益于《科学美国人》,它l984年9月号出了一期介绍当时出现的数字技术的专辑,并将我的一个视频编程实验选作封面图。一天,我接到编辑一个语气略显惶恐的电话,说没有看到标明我所属的单位。我解释说在那个时候我没有什么单位,也没有做过他们所说的工作“先生,”他告诉我说,“我们《科学美国人》有严格的规定,作者姓名后面必须标明所属的单位。”我顺口说出了“VPL研究”公司(VPL代表视频编程语言——Visual Programming Language或虚拟编程语言——Virtual programming Language),于是VPL就这样诞生了。这期杂志出版后,投资者纷纷打来电话,一家公司就实实在在存在。

20世纪80年代中期,VPL开始销售虚拟世界工具,并因它引进了手套装置而闻名于世这种手套装置刊载在l987年l0月号《科学美国人》的封面上。在上世纪80年代中期至晚期,VPL进行,我决定称之为“虚拟现实”的头一批实验。虚拟现实将虚拟世界与网络化结合起来.利用头戴显示器使多个参与者置身于一个虚拟空间。1989年,VPL开发了新的被称为RB2的产品。RB2是Reality Built for Two”(为两人建立的现实)的缩写,它允许两名参与者共享一个虚拟世界。虚拟现实的一个饶有兴趣的意味就是参者必须能够看到彼此的表演,他们往往被称为“化身”。虽然当时计算机能力有限,我们的早期化身只是一些极为简单的通式计算机图形,面孔仅粗略地与参与者相似,然而他们却真实地传递了真身的动作,因此使我们感觉到真人的存在,感受到他们的情感和兴趣所在。

我们的虚拟世界最初仅仅能短距离共享,但我们也进行了一些长距离应用实验。我们曾成功地组织了日本与加利福尼亚及德国与加利弗尼亚的参与者之间的虚拟现实对话。这些演示并未使网络的负担过重,因为需要传送的仅是参与者的动作,而不是像远程沉浸那样要传送每个人的外貌。

计算机网络研究是与虚拟世界研究同一年代开始的。20世纪60年代晚期,孕育了最早的一个网络——Arpanet,在它的激励下,产生了其他的网络,这些网络在上世纪80年代全都并入Internet。随着Internet的发展,建立了各种各样的“主干网”。所谓主干网,就是网络中的这样一个网,它能让信息通过极为强大的广泛、连接较快速地传送远处,为支持研究工作而设计的一些著名的主干网。20世纪80年代晚期的NSFnet和90年代中期的vBNS,每一个这样的主干网都在Internet鼓舞人心的新应用(例如万维网)中起过某种作用。另一个被称为Abilene的主干网研究项目开始于1998年.它是为被称为Intemet2的大学集团网络服务的。

Abilene目前网罗了170多所美国研究大学。如果Intemet2的目的仅是提供宽带宽(即每秒钟传送大量比特),那末光有Abilene和相关资源的存在便已足够了。但是Internet2研究还瞄准了其它目标,其它包括开发处理应用程序的新协议,这些协议要求非常宽的带宽非常少的延迟时间(信号处理途中的延迟)。

Internet2有过一个特殊的问题:现有的应用程序没有一个要求预先考虑的性能级别。计算机科学一向都是以教授的猜想为发展动力的,即使我们并不总是事先知道速度较快、能力较强的数字工具用处何在,也总设想它们是很有用的。但是,对高级网络研究的情况,光有这种信念是不够的。新的设想应该在某种东西身上进行试验。

Allan H.Weis在NSFnet的建设过程中起过核心作用,他领导着一个名为“先进网络和服务”的非盈利组织。Internet2的工程办公室即设于其中并受其管理。他用“远程沉浸”这个术语来谑称理想的“驱动”应用程序,并求我作为“国家远程沉浸创新公司”的主任科学家来承担编写这个应用程序的任务。我感到很高兴,因为这正是我在共享虚拟世界方面先前工作的逻辑延伸。

尽管在我们能够享用可供使用的远程沉浸系统之前,仍有许多部件,诸如显示系统,有待发明或完善,但巨大的挑战却开辟了一条合适的可视地感知人物和场所之途径。至于为什么这个问题不同于电视会议,目前可能还不能立即取得明确的答案。

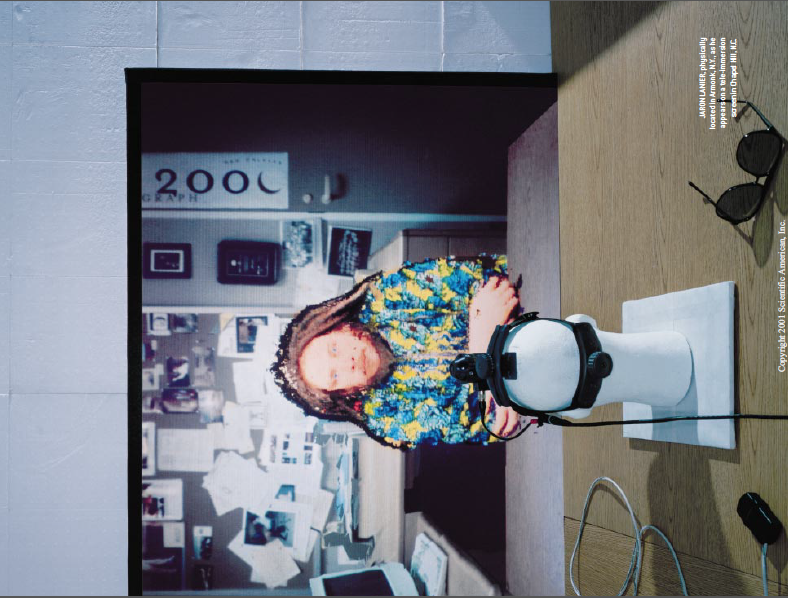

透过偏光眼镜看出去,电视室的两堵墙渐化为窗户,露出了几间办公室,办公室里的人回过头来看着我。

在我们所知的摄像机之外

关键问题是,在远程沉浸中,每位参与者必定对遥远的景象都有一个个人视点——实际上是两个,因为每只眼睛必定从自己的角度来观察事物以保存深部的景象。不仅如此,参与者还应该能够自由地走来走去。使每个人的视点都处于恒定的运动之中。

远程沉浸要求每个景象不偏向任一特定的视点的方式来被感知(摄像机则相反,它被锁定从自己的位置来描述景象)。每个场所以及该场所中的人和物都必须同时从所有的方向被感知,并且好象是动画般的三维雕像那样被传送。每个遥远的地点接受描绘整个运动着的雕像的信息,并像当地所要求的那样描绘视点扫描过程必须快速、实时地完成,最多只允许几分之秒钟。这样,描绘人物的雕像就能迅速地更新。从而获得连续运动的影像。大约每秒钟12.5帧时影像开始出现,大约每秒25帧时影像变得更健全,帧速越快,效果越好。

测量一间房子中的人和其中的其它物件的运动着的三维轮廓的工作可以用不同的方法完成。早在1993年,教堂山北卡罗来纳大学的Henry Fuchs就提出了一种被称为“多视点摄像机”的方法,在此方法中比较了许多摄像机的视点。在人群环境的典型景象中,倾向于要有可见的特征,例如有一架以上的摄像机可以看到的运动衫褶子。比较这些特征被不同摄像机看到的角度,藉助于算法可以将其合并在一起,拼成这个景象的三维模型。

这种技术用非实时配置进行过研究,比较著名的有Takeo Kanade的研究工作。据1995年的报道,后来在卡内基·梅隆大学的 “虚拟现实”演示会上受到强烈关注。这套装置由安装在测地穹窿上的51部内视摄像机所组成。因为它不是实时装置,所以不能用于远程沉浸。它是由磁带录像机抓取穹窿中的事件以供日后处理。

宾州大学GRASP(通用机器人学、自动化、传感和感知)实验室主任Ruzena Bajcsy对实时多视点摄像机的概念产生了等产生了兴趣。从1994年开始,她与北卡罗来纳大学和卡内基梅隆大学的同事一道,用两三部摄像机收集了供虚拟现实应用的现实世界数据。

Bajcsy和她的同事Kostas Daniilidis承担了开发第一台实时多视点摄像相机的任务。这种摄像机是可伸缩的和模块化的.因此适合于各种不同的空间和用途。他们与负责采集“动画化雕像”数据并利用计算机图形技术将其转化为每个用户的现实景象的北卡罗来纳大学科研小组紧密合作。

但是,多视点摄像机本身并不是一个圆满的解决方案。假设用它拍摄一堵洁净的白色墙壁,由于墙上没有表面特征,因此它无法取得用于建立雕像模型的信息。人则能看着白墙而不致弄错。我们不会担心一堵墙可能实际上是通往白色无底深渊的通道,因为我们不仅仅依赖几何学的线索。我们心中还有房间的模型,因此能够控制思想中的错误解释。不幸的是,对今天的数码摄像机来说,人的额头或T恤衫能像一堵白墙一样提出同样的挑战,而今天的软件并没有智能化到足以消除这样的混乱。

北卡罗来纳大学的研究人员提出了一种可能克服这一障碍的方法,这种方法被称为“不可察觉的闪烁光”(ISL)法。普通的灯泡每秒闪烁50或60次,其速度快得足以使人眼通常看不见这种闪烁。同样地,ISL像一个普通灯泡一样作为一种连续白光源呈现在人的眼前,但事实上,它充满了快速变化的图案,只有专业化的精确同步的摄像机才能看得见。这些图案充满着空间,就像附加有许多特征的白墙,使多视点摄像机得以完成测量。

惊喜时刻

2000年5月9日,我们得以首次演示远程沉浸,虚拟地将三个地点并在一起。在北卡罗来纳大学的电视室里有十几位高层领导,我们和他们在模拟的未来办公室里依次坐下。就像导致这次演示的三年研究工作那样,这情景令我神魂颠倒,体验远程沉浸所带来的快乐是出乎意料且无与伦比的。透过一副偏振光眼镜望去,电视室的两堵墙渐化为窗户,露出其它的办公室,其中有其他人回过头看着我。(偏振光眼镜使每只眼睛所看到的景象略有不同,从而产生了立体视觉效果。)透过一堵墙我和我在纽约阿蒙克试验室的研究人员Ainela Sadagic打了个招呼。另一堵墙外是宾州大学的博士后研究生Jane Mulligan。

与我研究多年的卡通式虚拟世界不同的是,我现在所看到的远方的人和地方明明白白地来源于现实世界。当然,他们一点也不完美。系统中存在着“噪音”,使他们看起来像是飘散在其他人办公室里的五彩纸屑。帧频很低(每秒2~3帧),有长达1秒钟的延迟,谈话者只有一方实现远程沉浸显示。但是,这里的确是一个虚拟世界,它不是真实世界的过分简单化的艺术表现形式,而是有根有据的基于测量最终结果的真实世界的再现。

在稍后(2000年10月)的一次演示中,五彩纸屑大部分消失了,系统的总体质量和速度都有所提高,但是最重要的改进却是由Andries van Dam领导的布朗大学的研究人员作出的。他们来到远程沉浸会场,带来了不是由物理景象衍生的虚拟客体。我坐在布朗大学的RobertC.Ze—leznik对面的桌子旁边。他当时身处我在阿蒙克的试验室,他拿出一个模拟的微型办公室内景(大约2英尺宽),放在我们之间的桌子上。我们一边交谈,一边用模拟的激光指示器和其它器件修饰墙壁和房内的家具。这是一次可圈可点的利用与虚拟现实结合的模拟的实验。

我们何时可以用上远程沉浸?

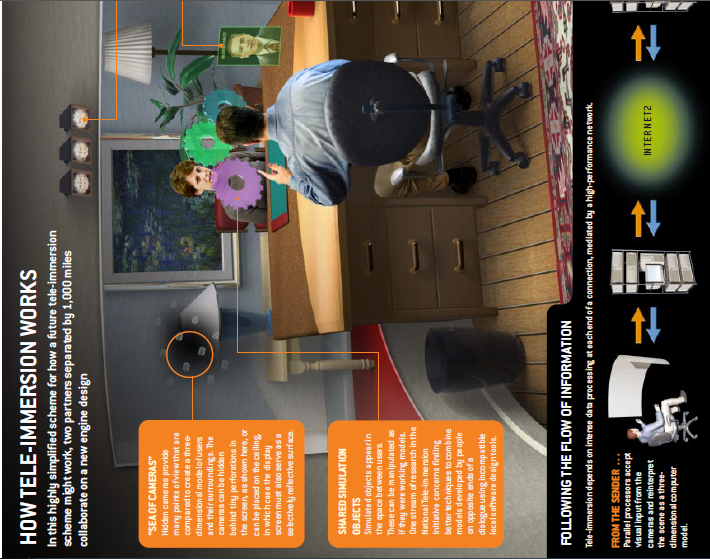

除了景象捕获系统,一套远程沉浸装置的主要组成部分是计算机、网络服务以及显示和互动设备。每个组成部分都已经为远程沉浸进行了超前研究,而且必须进一步超前。远程沉浸是胃口特大的计算机资源消费者。我们选择尽可能地采用商品计算机部件(即那些也用于普通家庭和办公室产品的部件)以促进远程沉浸可以在实验室范围之外使用的日子早日到来,可以毫不夸张地说,为了满足远程沉浸的要求,每个站点目前需要数十个这样的处理器。它们或者是排列在架子上的装在塑料机箱中的个人计算机,或者是装在冰箱大小的机柜中的电路板。

多数处理器的任务是采集景象。一多视点摄像机由若干交迭的摄像机三件套组成。此时我们一般用7部摄像机组成的阵列来拍摄一个坐在桌旁的人,实际上它起着五个三件套的作用。粗略地说,一簇8块共享内存的2GHz Pentium处理器应该能够在接近实时的时间里处理多视点摄像机中的一个三件套。这种处理器簇应该在今年晚些时候面市。尽管我们预期计算机的价格会像过去几十年一样一跌再跌,但仍需假以时日远程沉浸才能足够便宜以供广泛使用。预计开始时一个8处理器簇的价格将会是3万至5万美元,每个站点对它的需要量也是很大的(每个摄像机三件套需要一簇),而且这还没有考虑完成其它任务所需要的处理能力。我们还不知道远程沉浸某种规定的用途需要多少摄像机,但目前比较接近实际的猜测是,非正式谈话至少要求7部,而对于要求极高的应用,例如长距离外科手术演示、咨询和培训工作,则可能需要60部摄像机。

我们的计算机需求不限于处理多视点摄像机摄得的图像流。为了重新合成和描绘变化的景象,如在对话时参与者的头部摆动,我们需要更多的处理器。最初,我们使用一台定制的大型图形计算机,但是最近得以改用带低价图型卡的商品处理器,每只眼睛用一个处理器。为了完成其它的任务,如综合每一摄像机三件套的拍摄结果,处理不可察觉的闪烁光线,测量用户头部的摆动,维护用户界面以及执行虚拟客体模拟,都要求有另外的处理器。

此外,由于最大限度地减少视在等待时间是远程沉浸工程的核心问题,预测算法最终须利用大量的处理资源。通过光纤输送的信息到达目的地的速度约为自由空间中光速的2/3,因为信息是通过光纤介质输送而不是在真空中输送,也因为信息不是直线传输而是在光纤通道中不断反射。因此,在不允许任何其它不可避免的延迟例如各种网络信号路由器的工作所造成的延迟的情况下,受光纤约束的信息比特自西向东横跨美国大陆须费时25至50毫秒。

非常不幸的是,虚拟世界响应速率的某些重要方面容不得大于30至50毫秒的延迟。更长的延迟时间将使得用户感到疲劳和晕头转向,感到图像质量下降,在最坏的情况下,还会感到恶心。即使我们在两端用的都是速度极快的计算机,当我们横跨美国进行对话时,仍然须要进行预测以补偿延迟。这就是目前的测试站点为什么全都设在美国东海岸的一个原因。

今后几年一个可能解决问题的研究途径将是通过远程超级计算机中心实时地进行路由远程沉浸处理以获取超级计算能力。在这种情况下,超级计算机的速度应该非常之快,足以补偿从所在地往返传输时间所造成的额外延迟。

带宽是我们关心的重点,我们对带宽的要求随景象和应用而异;较复杂的景象要求较宽的带宽。我们可以设想,多数景象,特别像背景墙之类,是不会发生变化的,因此无须每帧都重复传送。现已证明,以每秒两帧的低帧频传输到在桌旁的一个人而不是显示其周围环境,所要求的带宽约为每秒钟20兆比特,最高要求达80兆比特。随着更先进的压缩技术的出现,这个数字将会下降。每个站点必须接受所有其他站点发来的信息流,所以,在三方通话中,带宽的要求必定会相应地成倍增加。先进的OC3线路每秒钟能输送155兆比特,正好足以支持低帧频下的三方通话。OC3线路的容量约100倍于目前的宽带连接,不过相应地更为昂贵。

我希望在未来几年我们将能看到不要求用户配带专用眼镜或利用任何别的装置的一种远程沉浸版本。纽约大学的KenPerlin已经开发了一种自动立体显示器的原型,可能使这个希望成为现实。

粗略地说,远程沉浸的成本约为其它通信技术的100倍,实在太昂贵了,目前难以和其它通信技术竞争,此外,它还需要进一步完善我的最乐观的猜测是,大约5年后,它将变得足够完善和足够便宜,可以有限地被采用,而要广泛利用,则大约需要10年。

展望

当远程沉浸变得普遍起来的时候,它将可能在很多方面获得重要的应用。若干个工程师小组可以远距离合作对新机器进行计算机化设计,像对共用工作台上的真实模型一样摆弄这些机器。世界各地的考古学家可以体验亲临重要发掘现场的感受。建筑监理或发动机维修高级专家不必浪费时间飞往各地便能进行实地视察。

事实上,远程沉浸可能即将被视为航空旅行的实际竞争对手,这一点是与电视会议不同的。尽管很少有人宣称远程沉浸近期会绝对地好到如同身处彼地”,但它却可能足以适用于商业会议、专业咨询、培训教学、商贸展览等等。10年以后,商业旅行可能在很大程度上被远程沉浸所取代,这不仅是因为远程沉浸将会变得更好和更便宜,而且还由于安全、土地利用和环境保护等原因,航空旅行将面临发展的限制。

远程沉浸可能对人际关系和人的作用产生惊人的影响。例如,有人担心,在Internet上文件可以广泛地被复制,著作权法将越来越难以实施,在这种情况下艺术家、音乐家和作家将何以谋生,于是,他们往往认为,因为个人的交互作用,当时产生的价值比事后从文件或录音录像产生的价值要大,为个人出场(出版或表演)付费是一个解决办法。远程沉浸能使艺术交流变得十分实用而廉价,足以为艺术的商业化提供一个另类基础。值得指出的是,在20世纪以前,所有的艺术都是互动的音乐家直接与听众交流,舞台上的演员和公园中的诗人也是如此。所有这些突显时效性、新切感和个人响应性的艺术的远程沉浸形式都可能出现,以解决著作权实施中的危机。

远程沉浸无疑也将提出新的挑战。某些早期用户已经表示担心,远程沉浸暴露得太多了,而电话和电视会议工具则较容易使参与者控制他们的暴露程度,因为他们可以挂断电话或离开屏幕。随着经验的积累,我们将能构想新的用户界面设计(如同本文50页至51页的插图所描绘的虚拟镜)和发现一些行为习俗以解决此类潜在的问题。我对此怀有希望。

有人常常问我,使用似乎对社会会产生深远影响可又无法知道这种影响是什么的新技术,是不是一件很可怕的事情?我的回答是,因为远程沉浸基本上是一种帮助人们更好地进行联系的工具,所以这个问题实际上是人们对关于人的本性究竟应该乐观到什么程度。我相信,通信技术将增加人们与对方的共同感和促进道德行为。因此,我是持乐观态度的,无论远程沉浸最终将扮演什么角色,它多半都会造福人类。

陈育真/译 徐彬/校

远程沉浸是如何工作的。在这幅表示未来的远程沉浸装置如何工作的高度简化的示意图中,两个相距10英里的搭档合作设计新发动机。

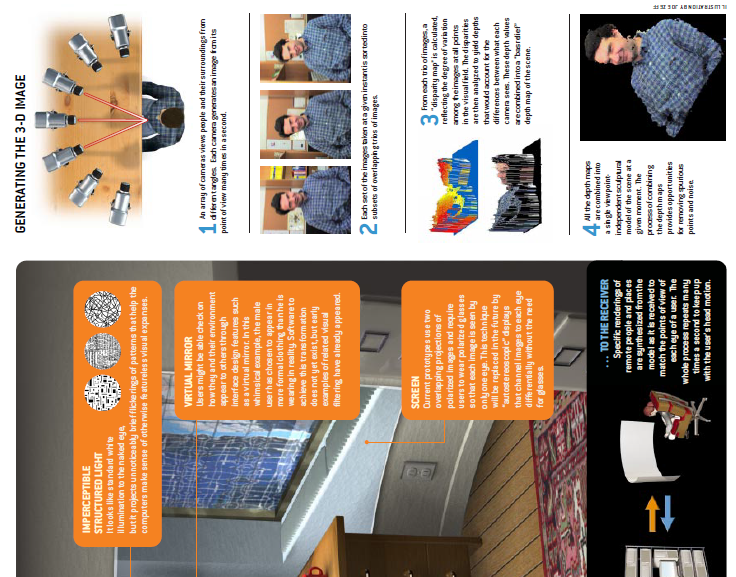

生成三维图像

1. 一排摄像机从不同的角度拍摄人以及周围的环境。每架摄像机从它的视点每秒钟多次地生成一幅图像。

2. 在一个给定的瞬间拍摄的每个图像集合被分成为互相重叠的三幅一组图像的子集。

3. 由每一三幅一组图像计算出“差异图”,反应可视域内所有点上图像之间的差异程度,然后分析这种差异性,得出考虑了每架摄像机所见景象之间的差异的景深。这些景深值最后被合成该景象的一幅“浮雕照片”景深图。

4. 所有的景深图合成该景象在给定的时刻的一个与视点无关的雕塑模型。景深图的合成过程提供了消除乱真点和噪音的机会。

七架摄像机在北卡罗莱大学的远程沉浸装置中可视用户。

请 登录 发表评论