今年,“末日之钟”(Doomsday Clock)又一次被向前拨动,而上一次拨动它是在2012 年。1945 年,曾参与曼哈顿计划的几位科学家成立了《原子科学家公报》(Bulletin of the Atomic Scientists)杂志,致力于研究人为因素对于人类文明生存的威胁。1947年,他们又设计了这个虚构的时钟,用来对世界末日进行理论上的倒计时(指针距离零点的远近象征着世界距离毁灭的远近)。由于气候变化带来的威胁,加之裁军步伐放缓,末日之钟现阶段的管理者将时钟向着子夜拨快了3分钟。

然而,我们所面临的威胁不仅仅是全球变暖和核武器。成立于2012 年的剑桥大学生存风险研究中心(Center for the Study of Existential Risk,简称CSER)正在评估新兴科技可能带来的潜在威胁,即那些人们还未考虑到的危险。该中心开发的科学方法可用于评估新的全球性风险,例如机器人统治世界只是科幻小说中的情节,还是有可能真实发生。一些世界上最聪明的人,包括史蒂芬·霍金(Stephen Hawking)、扬·塔林(Jaan Tallinn,Skype联合创始人之一)以及哲学教授休·普赖斯(Huw Price)均为上述评估方法的建立做出了贡献。

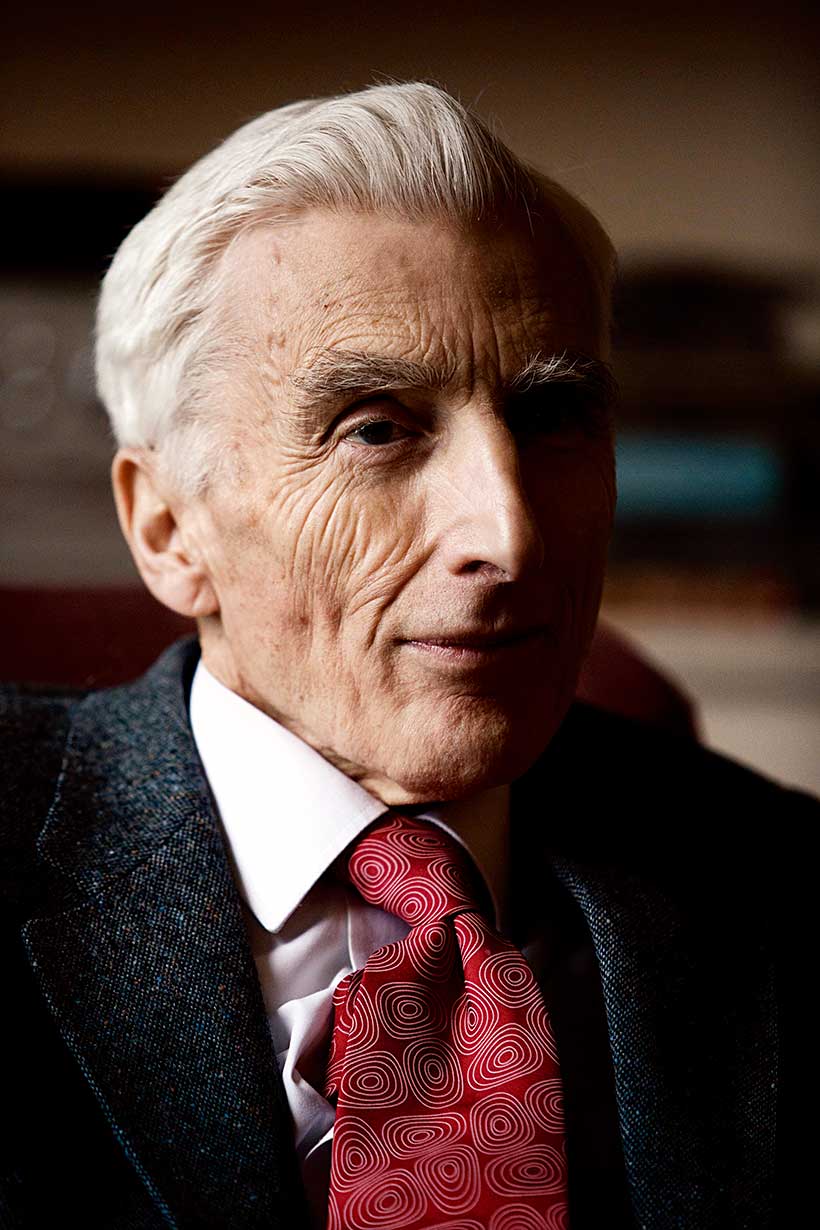

《科学美国人》采访了该中心的创办人之一、天体物理学家马丁·里斯勋爵(Lord Martin Rees),探讨可能终结人类生命的种种潜在威胁(以下为编辑后的采访节录)。

《科学美国人》:为何要成立这样一个组织,专门研究新兴科技的潜在威胁?

里斯:纵观历史,我们的祖先经历了各种危险:瘟疫、暴风雨、地震,还有人为制造的灾难。而现在,我们身处的时代已不同以往。这是首次有一个物种——也就是我们人类,可以决定地球的未来、人类文明以及我们后代的存亡。

《科学美国人》:你们会分析哪些具体情况?

里斯:目前,我们的专家在威胁出现的可能性及其影响方面存在巨大分歧。气候科学家对是否存在引发灾变的临界点意见不一。而人工智能专家对人工智能亦各持己见:一些专家认为,在本世纪中期人工智能可达到人类智力水平,并拥有自主思想,且它们的思想与我们有很大不同;另一些专家则认为,这一可能性很渺茫,并表示我们应该把注意力放在无自主思想机器人的伦理道德和安全管控方面,如军用无人机。此外,专家们还就生物技术的边界到底在哪儿,展开了激烈的辩论。我希望生存风险研究中心能协助各位专家,搞清楚哪些威胁出现的几率最大,并达成坚定的共识,将它们提到议事日程上,共同应对。

《科学美国人》:你认为哪些是人类的主要威胁?它们有多严重?

里斯:我个人对生物技术进步带来的危机持悲观态度。20 世纪70 年代,针对DNA 重组技术带来的生物安全风险,分子生物学的先驱们在阿西洛马会议(Asilomar conference)上提出了著名的指导方针。如今,此类问题则更加严峻。人们对新技术带来的伦理道德风险以及是否应谨慎运用充满了担忧,并展开了激烈的辩论,例如,对病毒进行的“功能增益”(gain of function)试验,以及对CRISPR基因编辑技术的运用。相比于20世纪70年代,现在我们的研究团队更加全球化、更具竞争力,也更易受到商业压力的影响。我担心的是,一些有利可图的危险的事情,只要在技术上可行,那么世界上总会有人付诸实践。尽管我们有规范这些新技术的正式的协议和准则,但执行起来却和禁毒法一样难。在未来10到20年内,“生物学错误”(bioerror,指一些不正确的生物学研究导致的后果)和生物恐怖袭击(bioterror)是我个人认为风险最高的事件。

《科学美国人》:有哪些情况是人们没有必要担心的?

里斯:许多生活在发达国家的人们过于担心一些概率很小的危险,比如食品中的致癌物质、低剂量辐射、飞机失事等。有些人过于担心发生小行星撞击,其实,这是天灾中最明显也最容易计算概率的事件。而且,通过人为让小行星的飞行轨道发生偏离,小行星撞击地球的风险也会很快降低。这也是我支持“B612哨兵计划”(B612 Sentinel project)的原因。我们更应该担心的是那些新兴的技术,它们值得我们投入更多的关注,这也是生存风险研究中心的工作重点所在。不熟悉的事件并不等同于不会发生的事件,这是一条重要的准则。对于风险极大的事件,即使我们只能将其发生的可能性降低一百万分之一,也仍然值得去努力。

请 登录 发表评论